미래를 위한 스마트 팩토리, 지능형 비전 시스템으로 시작하세요.

과거의 검사 방식인 육안 판별이나 하드코딩된 룰 베이스 시스템은 반복성과 정밀도에서 한계를 가졌습니다. 그 결과 예상치 못한 불량 납품과 고객 신뢰도 하락이라는 리스크가 발생합니다.

반면 머신 비전은 데이터 기반으로 학습하고 변화하는 패턴을 스스로 인식하며 고해상도 카메라와 알고리즘을 통해 육안보다 더 빠르고 정확하게 결함을 탐지해서 리스크를 줄일 수 있습니다.

자동차 부품, PCB 기판, 캐스팅, 도장 표면, 직물 패턴, 배터리 패키징, 로봇 셀 등 다양한 산업에서 머신 비전은 품질관리의 디지털 전환을 견인하고 있습니다.

이제 경쟁력을 높이는 새로운 기준을 도입할 때입니다. 머신 비전은 제조업 AI 혁신의 시작입니다. 다음 시대의 품질 전략입니다.

최신 기술은 단순한 도구를 넘어 기업의 미래 전략과 기술 대응 능력을 결정하는 핵심 자산으로 자리 잡고 있습니다. AI, 자동화, 데이터 기반 의사결정은 생산성과 비용 구조를 동시에 혁신하며, 빠르게 변화하는 시장 환경 속에서 기업이 장기적으로 생존하고 경쟁 우위를 확보하기 위한 필수 조건이 되고 있습니다.

제조업의 부활은 단순한 설비 확장이 아니라 AI 기술 도입을 통한 생산 구조의 근본적 전환에서 시작됩니다. 지능화된 공정 관리와 품질 예측, 자동화 시스템은 비용 절감과 생산성 극대화를 동시에 달성하며, 제조 기업이 불확실한 글로벌 환경 속에서도 지속 가능한 성장 기반을 구축하도록 지원합니다.

AI 패러다임의 변화는 기업이 기술을 활용하는 방식 자체를 재정의하고 있습니다. 단기적 자동화를 넘어 장기 생존 전략으로서 AI를 내재화하고, 현장 중심의 실질적인 적용을 통해 운영 효율을 높이는 것이 중요합니다. 이는 기술 대응 역량을 강화하고 미래 경쟁력을 선제적으로 확보하는 핵심 전략입니다.

제조업 분야의 품질 관리 및 자동 검사 시스템에 대한 머신 비전 기술의 수요는 매년 꾸준히 증가하고 있습니다. 자동화된 검사 시스템은 제품의 결함을 정확하게 식별하고, 오탐률을 줄이며, 축적된 데이터 기반의 패턴 학습을 통해 객체 인식의 정밀도를 높이는 데 핵심적인 역할을 합니다. 이러한 머신 비전 기술은 반도체, 자동차, 일반 제조업을 비롯해 헬스케어, 스마트 농업, 물류, 소매, 공공 안전 등 다양한 산업군 전반에 걸쳐 빠르게 확산되고 있습니다.

경량화 및 가속화 → 데이터 효율성→ 다중 모달리티 확장 기존의 로봇 제어는 특정 환경에서 수집된 데이터만을 학습하여 조금만 조건이 바뀌어도 대응하지 못하는 한계가 있었습니다. 연구자들은 인터넷상의 방대한 텍스트와 이미지 데이터를 학습한 거대언어모델의 추론 능력을 로봇의 실제 행동에 이식하고자 했습니다. 즉, 컵을 집어라 라는 추상적 언어를 어깨 관절을 15도 회전하라 라는 구체적 수치로 변환하는 의미론적 추론과 물리적 실행의 결합이 VLA 연구의 핵심 동기입니다. VLA의 핵심은 이질적인 데이터를 하나의 언어로 통일하는 것입니다. 로봇의 관절 각도, 그리퍼의 상태 등 물리적 수치를 텍스트와 같은 '토큰'으로 변환합니다. 이를 통해 트랜스포머 아키텍처는 시각 정보와 언어 명령, 그리고 로봇의 행동을 동일한 위계의 데이터 시퀀스로 처리할 수 있게 됩니다. 시각 인지에는 DINOv2나 CLIP 같은 인코더를, 사고 체계에는 Llama나 Qwen 같은 LLM을 백본으로 활용하여 사전 학습된 거대 지식을 로봇 제어에 전이시킵니다. VLA 모델은 특정 작업에 국한되지 않고 새로운 도구나 환경에서도 스스로 판단하고 행동하는 범용 파운데이션 모델로 발전하고 있습니다. 이는 제조 공정의 유연성 확보는 물론, 가사 조우 로봇 등 서비스 로봇 분야의 혁신을 가속화하고 있습니다. 휴머노이드 로봇에 적용된 VLA 모델은 단순히 말을 듣고 움직이는 것을 넘어, 복잡한 물리 세계의 법칙을 이해하고 실시간으로 정밀한 동작을 생성하는 로봇의 뇌 역할을 합니다. 엔비디아의 GR00T N1.5는 다양한 형태의 휴머노이드 로봇에 이식 가능한 범용 파운데이션 모델로 공개되었고 Figure AI의 Helix는 온디바이스에서 직접 추론이 가능한 효율적인 VLA 구조를 선보이고 있습니다. 거대 모델을 엣지 기기에서 실시간으로 돌리기 위한 최적화 기술 Quantization, Speculative Decoding이 필수적이기 때문에 경량화가 필요하고 수십 개의 시연 데이터만으로 새로운 작업을 배우는 Few-shot 능력으로 진화하고 있습니다. 또한 단순 이미지를 넘어 깊이, 촉각, 소리를 동시에 처리하는 VLA+ 모델로 확장 중입니다. VLA는 멀티 임바디먼트와 온디바이스 LLM으로 통합되는 방향으로 가고 있습니다.

2023년 7월, 2025년 6월 11일, 2026년 1월

육안 → 비전 → CNN → ViT, GAN 육안 검사에서 CNN이 표준 기술로 자리잡기까지는 약 40년이 걸렸습니다. 오늘날 제조업 검사 시스템에서는 Vision Transformer(ViT)와 비지도 학습 기반의 GAN 기술이 상용화 되었고 앞으로의 검사 기술은 단순히 불량을 식별하는 것을 넘어서, 불량을 사전에 예측하고 그 원인을 설명해주는 기술이 표준화될 전망입니다. 또한 고성능 GPU의 가격이 제조기업에 부담이 되지 않는 수준으로 하락하면서 내부의 인적 자원만으로도 고도화된 품질 관리가 가능한 시대로 접어들고 있습니다. 이러한 차세대 검사 시스템은 불과 10년 이내에 산업 현장에 보편화될 것으로 예상합니다. 이같은 기술을 선도적으로 연구 중인 말레이시아의 기업 ViTrox는 반도체 및 전자 패키징 산업 분야에서 ViT 기반 비전 검사 기술을 개발하고 있습니다. 2024년 6월, 대만에서 열린 COMPUTEX에서 NVIDIA CEO 젠슨 황(Jensen Huang)은 제조업 생태계의 중요성을 강조했으며 ViTrox는 엣지 AI 생태계의 핵심 플레이어로 그 역할을 확대해 나가고 있습니다. [영상 : NVIDIA CEO Jensen Huang Keynote at COMPUTEX 2024]

공개일 : 2024년 6월 2일

제조업에서 NVIDIA Jetson Nano 키트로 경량 CNN 모델을 구현한 연구 사례를 소개합니다. 결함 감지에 사용된 이미지는 직물(원단결함), 금속표면(볼 스크류), 주조(펌프 임펠러) 등과 같이 우리 제조업 현장에서 흔히 볼 수 있는 생산품입니다. 합성곱 신경망(CNN) 모델은 높은 정확도를 보이는 대신 고성능 컴퓨팅이 요구됩니다. 리소스가 부족한 산업현장에서 비용부담이 낮은 엣지 컴퓨팅과 최적화된 경량 CNN 모델이 제한적 제조업 여건에 특화되도록 설계했습니다. 그 결과 정확도가 높은 결함 감지 능력을 증명하는 동시에 소규모 컴퓨팅 자원이 제조업 워크플로우에 통합될 수 있음을 엿볼 수 있습니다. [출처 : Lightweight CNN Models for Product Defect Detection with Edge Computing in Manufacturing Industries]

공개일 : 2023년 4월

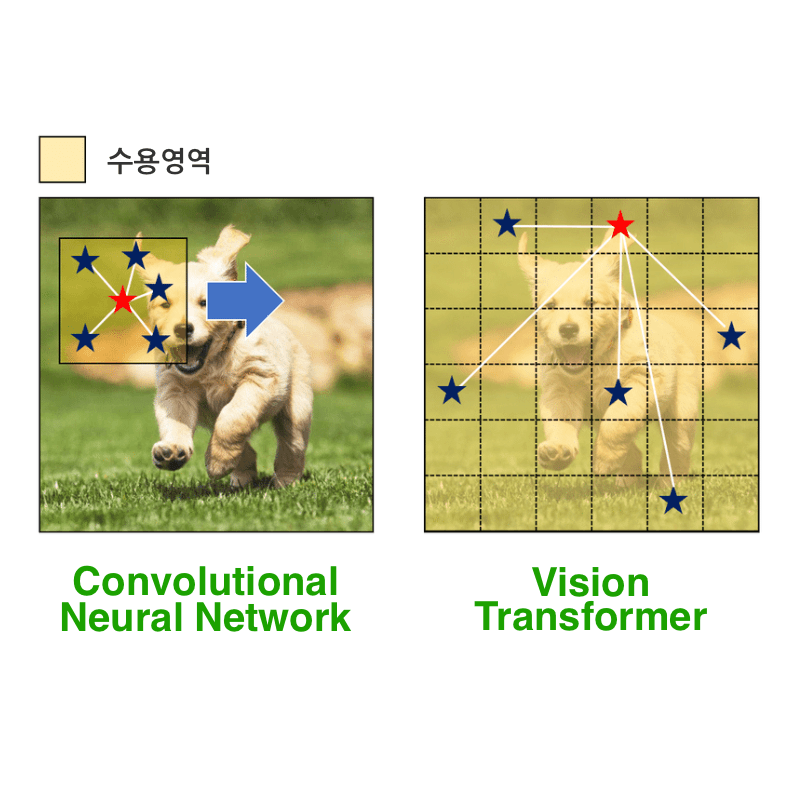

귀납적 편향(Inductive Bias): ViT는 더 약한 귀납적 편향(경험기반 가정)을 가집니다. 대신 셀프 어텐션을 통해 이미지의 멀리 떨어진 부분 간의 관계를 포함한 패턴을 데이터로부터 직접 학습하는 데 더 많이 의존합니다. CNN는 컨볼루션 및 풀링 레이어를 통해 지역성(locality)과 변환 불변성(translation equivariance)이라는 강한 내재적 편향을 가집니다. 이는 CNN이 이미지의 지역적 특징을 효과적으로 학습하는 데 도움을 줍니다. 데이터 의존성: ViT는 일반적으로 최신 CNN보다 우수한 성능을 발휘하려면 대량의 훈련 데이터(또는 광범위한 사전 훈련)가 필요합니다. CNN은 더 작은 데이터셋의 경우 내재된 편향 덕분에 종종 더 잘 일반화됩니다. 계산 비용: ViT는 훈련은 계산 집약적이며 상당한 GPU 리소스를 요구할 수 있습니다. 하지만 추론 속도는 특히 대규모 모델의 경우 경쟁력이 있을 수 있습니다. CNN은 일반적으로 훈련 및 추론 모두에서 더 효율적인 경우가 많습니다. 문맥 포착: ViT는 초기 레이어부터 패치 간의 전역적인 상호작용을 모델링하여 더 넓은 문맥을 더 효과적으로 포착할 수 있습니다. CNN은 지역적인 패턴을 기반으로 계층적인 특징을 구축합니다. •비전트랜스포머 : 자연어 처리(NLP) 분야를 위해 개발된 트랜스포머 모델을 이미지 인식 분야에 적용한 신경망 아키텍처입니다. 논문은 구글 연구원들에 의해 소개되었습니다. An Image is Worth 16x16 Words. 이미지를 픽셀 단위가 아닌 작은 패치들의 시퀀스로 처리하여 이미지 분석을 시퀀스 모델링 단위로 분류하는 특징이 있습니다. •합성곱신경망네트워크 : 1980년 컴퓨터 과학자 후쿠시마 구니히코가 생물학적 시각 시스템에서 영감을 받아 합성곱 계층과 풀링 계층으로 구성한 네오코그니트론(Neocognitron)이라는 개념을 만들었습니다. 이후 얀 르쿤이 손글씨 우편번호 인식에 CNN에 역전파(Backpropagation) 알고리듬을 사용하여 비선형 CNN을 처음으로 학습시키는 논문 Backpropagation applied to handwritten zip code recognition을 발표하였습니다. 이어서 1998년 얀 르쿤은 더 깊고 큰 구조의 LeNet-5 모델을 발표하면서 CNN 아키텍처의 고전 형태로 자리 잡았습니다.

공개일 : 2020년, 1998년, 1989년

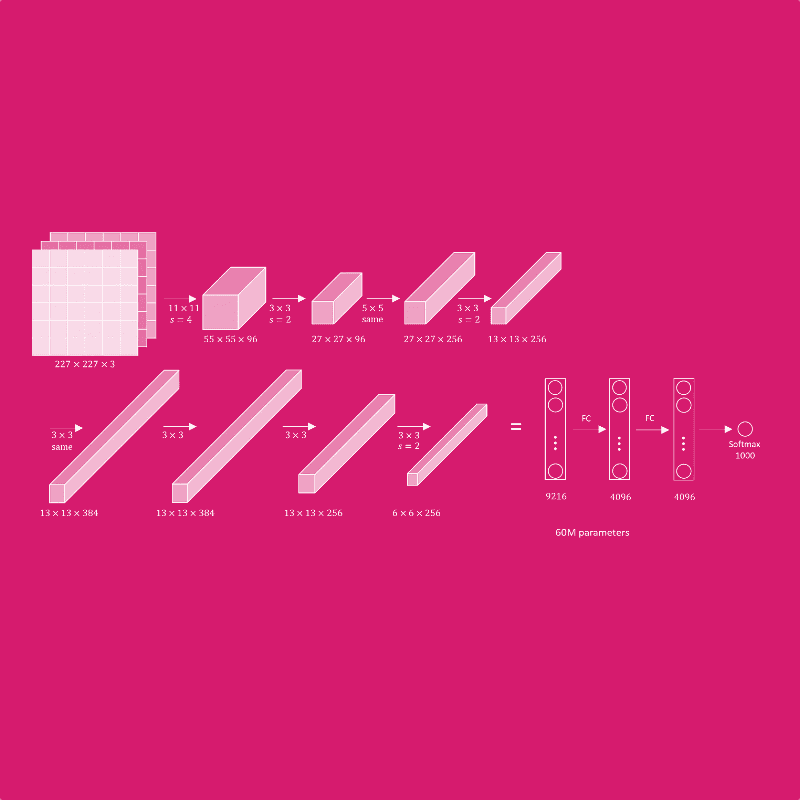

AlexNet은 ReLU 활성화 함수, Dropout, Max Pooling 등의 기법을 사용하여 높은 성능을 기대할 수 있습니다. 또한 더 깊고 복잡한 CNN 모델에 응용할 수 있어 다양한 이미지 인식과 결함 감지 요구에 대응이 가능합니다. 알렉스넷은 5개의 합성곱층(Convolutional Layer)과 3개의 완전 연결층(Fully Connected Layer)으로 총 8개의 계층 구조를 가지고 있습니다. 다중 GPU를 이용할 수 있기 때문에 병렬연산에 매우 유리하여 풀링 계층(Overlapping Pooling)에서 겹치는 영역을 이용하여 과적합을 줄이고 성능을 극대화 합니다.

공개일 : 2012년 9월 9일

인텔리전트 비전 시스템은 단순히 이미지를 보여주는 것을 넘어섭니다. 이 시스템은 마치 사람의 눈과 뇌처럼 주변 환경을 인식하고 이해할 수 있습니다.

예를 들어, 공장에서는 불량품을 자동으로 찾아내고, 자동차에서는 보행자를 인식하여 사고를 예방할 수 있습니다.

또한, 수집된 데이터를 분석하여 더 똑똑한 의사 결정을 내릴 수 있도록 돕습니다.

Intelligent vision systems do more than just show images.These systems can recognize and understand their surroundings, just like human eyes and brains.

For example, in factories, they can automatically find defective products. In cars, they can recognize pedestrians and help prevent accidents.

Also, they can analyze collected data to help make smarter decisions.

•품질 관리 향상: 제품의 결함, 불량 등을 자동으로 검사하여 인간의 눈으로는 놓치기 쉬운 결함까지 정확하게 감지할 수 있습니다. 이는 불량률 감소, 제품 신뢰도 향상으로 이어집니다. •생산성 증대: 반복적이고 정밀한 검사를 자동화하여 작업 시간을 단축하고 생산량을 늘릴 수 있습니다. 또한, 24시간 가동이 가능하여 생산성을 극대화할 수 있습니다. •비용 절감: 시스템 도입으로 검사 인력을 줄이고, 불량품 발생 감소로 인한 재료비 절감, 생산성 향상으로 인한 전체적인 생산 비용 절감 효과를 얻을 수 있습니다. •안전 강화: AI 비전 기술은 위험한 작업 환경에서 작업자를 대신하여 설비 이상을 감지하거나, 작업자의 안전 수칙 준수 여부를 확인하여 산업 재해를 예방하는 데 기여할 수 있습니다. •데이터 기반 의사 결정 지원: 검사 데이터를 실시간으로 수집하고 분석하여 생산 공정 개선, 설비 유지 보수, 품질 예측 등 다양한 의사 결정에 활용할 수 있는 정보를 제공합니다. 이러한 장점으로 제조산업은 AI 기술을 통해 생산성을 높이고 비용을 절감하며 제품 품질을 향상시키고 작업 환경을 더욱 안전하게 만들 수 있습니다.

이미지 처리 분야에 Transformer 아키텍처를 도입한 모델로 이미지를 패치(졉치지 않는 Patch) 시퀀스로 분할한 후, 각 패치를 벡터 임베딩하여 마치 자연어 처리의 단어처럼 취급하고, 이를 Transformer의 인코더에 입력하여 이미지의 전역적인 관계를 학습하는 딥러닝 모델입니다. 이미지 전체 영역에 걸친 상관관계를 어텐션 메커니즘으로 학습하여, 지역적 특징 추출 한계를 보완할 수 있어 엄청난 양의 이미지 데이터로 사전 학습될 때 CNN 기반 모델보다 뛰어난 성능을 보입니다. 따라서 모델 크기를 늘릴수록 성능 향상이 높아지는 특징이 있습니다. •쉬운 풀이 : 자연어처리에서 쓰이던 Transformer를 이미지 인식에 도입한 모델로 CNN 아키텍처를 쓰지 않고도 시각 정보를 학습할 수 있습니다. 대용량 데이터셋 처리에 뛰어나서 중소규모 엣지 컴퓨팅 보다는 고성능 컴퓨팅 기반의 대규모 데이터 환경에 적합합니다.

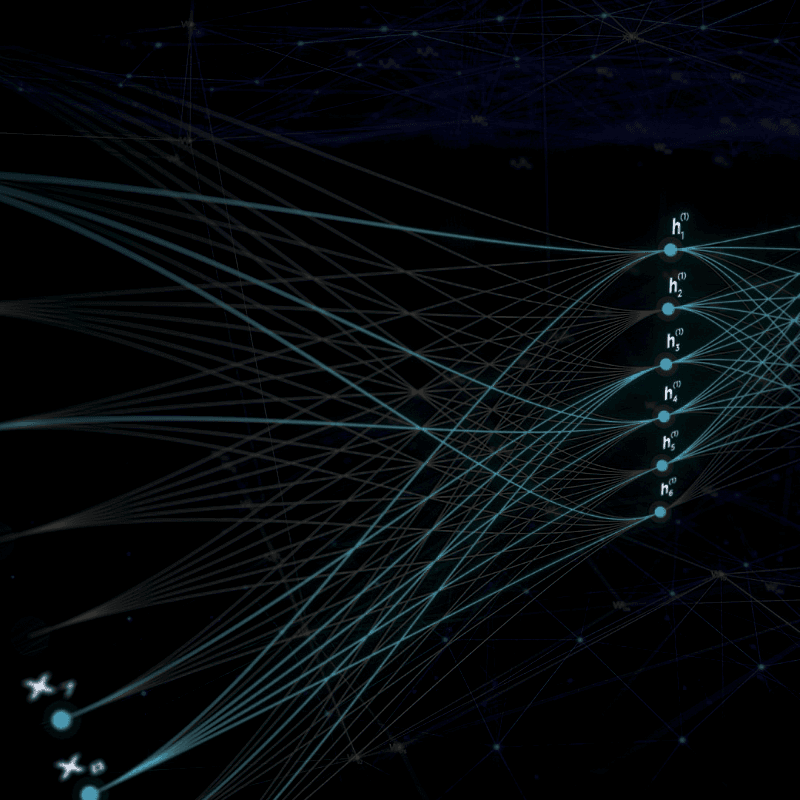

패턴 인식 (Pattern Recognition): 머신 비전의 핵심은 이미지에서 의미 있는 패턴을 인식하는 것입니다. 초기 통계적 패턴 인식 이론과 알고리즘 개발은 머신 비전의 기반을 다졌습니다. (예: Fisher의 선형 판별 분석 (Linear Discriminant Analysis)) 이미지 처리 (Image Processing): 이미지의 품질을 개선하고 특징을 추출하기 위한 초기 이미지 처리 기술 개발은 필수적이었습니다. (예: 디지털 이미지 처리 관련 초기 연구) 합성곱 신경망 (Convolutional Neural Networks, CNN): CNN은 이미지 내의 공간적 계층 구조를 학습하는 데 탁월하며, 결함의 위치와 형태를 파악하는 데 매우 효과적입니다. 특히, 작은 결함의 특징을 추출하는 데 강점을 가집니다. 하나의 필터는 하나의 특징 맵을 생성합니다. 따라서 여러 개의 필터를 사용하면 입력 이미지에서 다양한 특징을 추출하여 여러 장의 특징 맵을 얻을 수 있습니다. 특징 맵의 각 픽셀 값은 입력 이미지의 해당 위치에서 필터가 감지한 특징의 강도를 나타냅니다. CNN은 여러 개의 합성곱 레이어를 쌓아서 구성됩니다. 첫 번째 합성곱 레이어는 주로 입력 이미지의 가장 기본적인 특징(예: 모서리, 색상 등)을 추출합니다. 이후 레이어들은 앞선 레이어에서 추출된 특징들을 조합하여 더 복잡하고 추상적인 특징(예: 객체의 일부분, 질감 등)을 추출합니다. 마지막 레이어에 가까워질수록 추출되는 특징은 최종 목표(예: 객체 분류, 결함 탐지 등)에 더 특화된 고수준의 의미 있는 정보가 됩니다.

하이브리드 머신 비전입니다. 정밀한 인식에 최적화된 ViT와 산업 전반에 대중적으로 사용되는 CNN 그리고 실용적으로 평가받는 비지도 학습 GAN을 조합할 경우 최상의 결과를 얻어낼 수 있습니다. 특히 GAN, PatchCore, FastFlow 모델은 제조업 현장에 축적된 데이터가 부족하고 비용이 제한적일 때 경량 모델 중심으로 설계할 수 있습니다. 경량 모델의 비중을 높이고 비전 트랜스포머의 비중을 낮춰 초미세 결함 탐지 능력을 추구할 수 있습니다. •CNN(Convolutional Neural Network) 기반 : 다양한 제조업 현장에 구축이 용이하며 정밀한 위치 파악에 뛰어남 •ViT(비전 트랜스포머) 기반 : 불규칙한 패턴을 탐지하면서 전체 문맥을 파악하여 미세한 탐지에 효과적 •GAN(Generative Adversarial Networks) 기반 : 데이터가 부족하면서 복잡한 결함 대응에 효과적

[CNN(Convolutional Neural Network)] •정의: CNN은 주로 이미지 데이터를 처리하도록 설계된 신경망의 한 종류입니다. 합성곱(Convolution) 연산을 통해 이미지의 특징을 추출하고, 풀링(Pooling) 연산을 통해 차원을 축소하여 계산 효율성을 높입니다. •작동 방식: 합성곱(Convolution): 입력 이미지에 필터(Filter)를 슬라이딩하면서 특징 맵(Feature Map)을 생성합니다. •풀링(Pooling): 특징 맵의 크기를 줄여 중요한 정보만 남깁니다. •완전 연결 계층(Fully Connected Layer): 추출된 특징을 기반으로 이미지를 분류합니다. •특징: 이미지의 공간적 특징을 잘 포착합니다. 파라미터 공유를 통해 모델의 복잡도를 줄입니다. 이미지 분류, 객체 검출, 이미지 분할 등 다양한 작업에 활용됩니다. •응용 사례 및 기대 효과 - 제조업: 제품 불량 검사 자동화, 부품 분류 및 식별, 생산 라인 모니터링 (효율성 증대, 품질 향상, 비용 절감) - 의료: 의료 영상 분석을 통한 질병 진단 보조, 수술 로봇 시각 인식 (정확성 향상, 진단 시간 단축, 의료 서비스 접근성 향상) - 자율 주행: 차선 인식, 표지판 인식, 보행자 감지 (안전성 향상, 교통 효율 증대, 운전자 편의성 증대) - 소매: 상품 인식 및 재고 관리 자동화, 고객 행동 분석 (운영 효율성 증대, 고객 만족도 향상, 매출 증대) [R-CNN (Region-based Convolutional Neural Network)] •정의: R-CNN은 객체 검출을 위해 제안된 초기 딥러닝 기반 모델입니다. 입력 이미지에서 객체가 있을 법한 영역(Region Proposal)을 추출하고, 각 영역에 대해 CNN을 적용하여 객체를 분류하고 위치를 추정합니다. •작동 방식: 영역 제안(Region Proposal): Selective Search 등의 알고리즘을 사용하여 객체가 있을 가능성이 높은 영역을 추출합니다. •특징 추출(Feature Extraction): 각 제안된 영역에 대해 CNN을 적용하여 특징 벡터를 추출합니다. •객체 분류(Object Classification): 추출된 특징 벡터를 SVM(Support Vector Machine) 등의 분류기에 입력하여 객체의 클래스를 분류합니다. •경계 상자 회귀(Bounding Box Regression): 객체의 위치를 더 정확하게 추정하기 위해 경계 상자를 조정합니다. •특징: 객체의 위치와 클래스를 정확하게 검출할 수 있습니다. 계산량이 많고 처리 속도가 느립니다. •응용 사례 및 기대 효과 - 보안: 얼굴 인식, 침입 감지, 이상 행동 감지 (보안 강화, 범죄 예방, 안전한 환경 조성) - 농업: 작물 질병 진단, 수확 로봇 시각 인식, 드론 기반 농작물 모니터링 (생산성 증대, 농약 사용량 감소, 친환경 농업) - 물류: 화물 분류 및 추적, 포장 상태 검사, 로봇 팔 물체 인식 (물류 효율성 증대, 배송 정확도 향상, 인건비 절감)